로지스틱 회귀 모델을 이해하기 위해서는 로지스틱 함수(Logistic Function)와 승산(Odds)에 대한 이해가 선행되어야 한다.

로지스틱 함수는 S자 모양의 곡선으로, 출력값을 0과 1 사이의 값으로 제한하는데

Logistic Regression은 이 함수를 사용하여 종속 변수가 각 클래스에 속할 확률을 예측하며,

이 예측 결과를 기반으로 분류를 수행한다.

** 실제 현상에서 특정 변수에 대한 확률값이 선형이 아닌 S-커브 형태를 따르는 경우가 많은 실제 현상에서

로지스틱 함수(=시그모이드 함수)를 적용한 해결이 가능하다.

로지스틱 함수

- x값으로는 어떤 값이든 받을 수 있지만, 출력 결과는 항상 0에서 1 사이의 값을 가진다.

- 즉 확률밀도함수(probability density function) 요건을 충족시키는 함수이다.

승산(Odds)

- 승산이란, 임의의 사건 A가 발생하지 않을 확률 대비 일어날 확률 P(A)의 비율을 뜻하는 개념이다.

- 만약 P(A)가 1에 가까울수록 승산은 치솟고, 반대로 P(A)가 0이라면 0이 된다.

- 즉, 승산이 커질수록 사건A가 발생할 확률이 커진다.

로지스틱 회귀는, y가 연속형 데이터인 경우 적용하는 보통의 회귀 문제에 곧바로 적용할 수가 없어서 만들어진건데,

기존의 회귀식의 장점은 그대로 유지하되, 종속변수 y를 범주가 아니라 (범주1이 될) 확률로 두고 식을 세워보고자 하는 것이다.

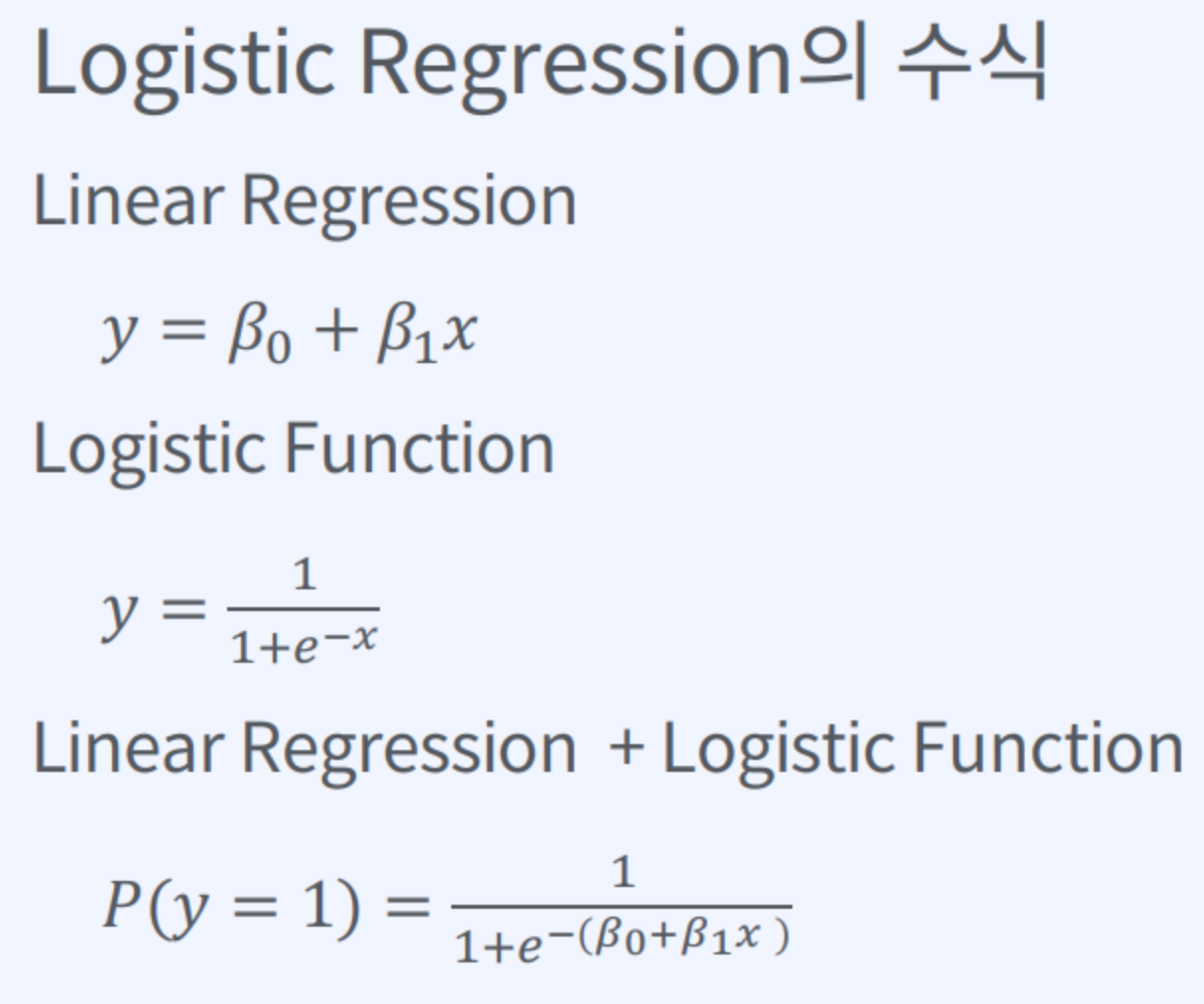

즉, Logistic Regression = Linear Regression + Logistic Function으로, 라벨이 범주형일 때 사용하는 Regression Model 이다.

https://ratsgo.github.io/machine%20learning/2017/04/02/logistic/

로지스틱 회귀 · ratsgo's blog

이번 포스팅에선 범주형 변수를 예측하는 모델인 로지스틱 회귀(Logistic Regression)에 대해 살펴보려고 합니다. 이번 글은 고려대 강필성 교수님과 역시 같은 대학의 김성범, 정순영 교수님 강의를

ratsgo.github.io

로지스틱 회귀(Logistic Regression)

로지스틱 회귀(Logistic Regression)는이진 종속 변수(또는 결과 또는 반응 변수로도 알려짐)와 하나 이상의 독립 변수(또는 예측 변수 또는 설명 변수로도 알려짐) 간의 관계를 분석하고 모델링하는

velog.io

'기초지식' 카테고리의 다른 글

| 분류 성능 평가 지표 (0) | 2024.05.09 |

|---|---|

| Ridge Classifier, Ridge Regression, L2 Normalization, L1 Normalization (0) | 2024.05.09 |

| SVM(Support Vector Machine) (0) | 2024.05.09 |

| XGBoost (0) | 2024.05.09 |

| Hyperparameter Optimization (0) | 2024.05.09 |